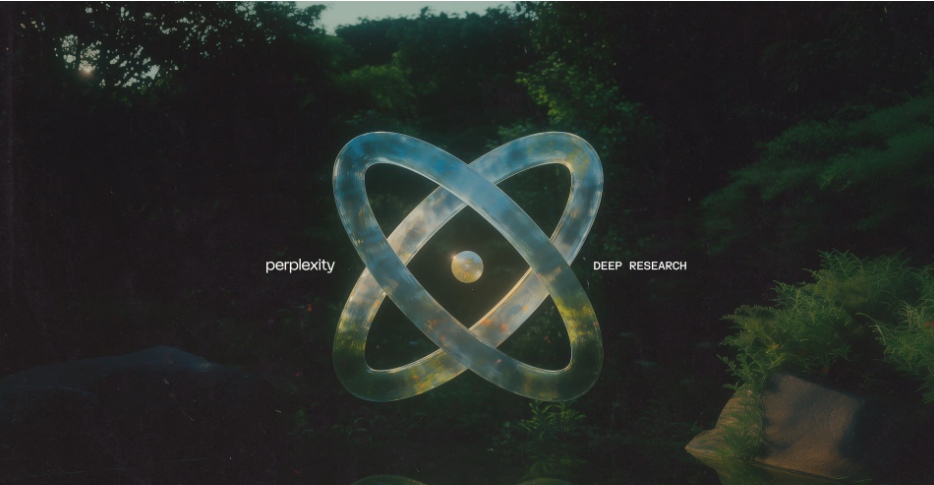

Perplexity lanza Deep Research: un salto en la automatización del análisis de datos

La inteligencia artificial sigue transformando la forma en que se accede y analiza la información. Perplexity ha lanzado Deep Research, una herramienta impulsada por IA diseñada para realizar análisis detallados en áreas como finanzas, marketing y tecnología.

Este sistema automatiza la búsqueda, evaluación y organización de datos, generando informes estructurados en cuestión de minutos. Un nuevo paradigma en la investigación Deep Research promete optimizar el proceso de análisis a través de tres funciones clave: Investigación iterativa: El sistema ajusta dinámicamente sus búsquedas y refinamientos, imitando la capacidad de los investigadores humanos para mejorar su enfoque en función de nuevos hallazgos.

Síntesis organizada: Tras revisar diversas fuentes, la herramienta presenta la información en un formato estructurado y coherente. Exportación y compartición sencilla: Los informes pueden exportarse en PDF, documentos o en una página de Perplexity para facilitar su difusión.

Según los datos de la compañía, Deep Research ha demostrado una precisión del 93.9% en Simple QA, un benchmark que mide la capacidad de la IA para ofrecer respuestas fidedignas, y un 21.1% en Humanity’s Last Exam, que evalúa su desempeño en más de 100 disciplinas, desde matemáticas e historia hasta literatura.

Implicaciones para la industria

La llegada de herramientas como Deep Research podría redefinir múltiples aspectos del trabajo analítico y de investigación: Eficiencia en la toma de decisiones: Empresas y académicos podrían reducir significativamente el tiempo dedicado a la recolección y procesamiento de información.

Democratización del acceso a datos: Investigadores independientes y pequeñas organizaciones podrían acceder a análisis detallados sin necesidad de equipos especializados. Nuevas tendencias en investigación: La automatización de búsqueda y síntesis podría llevar a un cambio en los métodos tradicionales, con un mayor enfoque en la interpretación y aplicación de la información. Desafíos en calidad de datos: Aunque el modelo muestra precisión elevada, su fiabilidad dependerá de la actualización y validación continua de la información.

Consideraciones éticas y privacidad: La recopilación masiva de datos podría generar inquietudes sobre seguridad y sesgos algorítmicos. Sobre este avance, Guillermo Reynoso, experto en SEO e Inteligencia Artificial de BIG Hacks, señala que herramientas como Deep Research podrían tener un impacto significativo en la optimización de estrategias digitales, al agilizar el acceso a información clave sin depender de análisis manuales prolongados.¿El futuro de la investigación está en la IA?

La automatización del análisis de datos avanza a pasos acelerados. Sin embargo, la confianza en estos sistemas dependerá de su capacidad para ofrecer información precisa, actualizada y libre de sesgos. ¿Estamos preparados para delegar decisiones estratégicas en herramientas impulsadas por inteligencia artificial?